GPT-5 יוצא בקרוב, וכולם מדברים על זה. אבל השאלה האמיתית היא – האם הוא באמת יכול לעזור לנו לנתח מה המתחרים עושים? או שזה עוד באזז מנופח?

תכלס, אחרי 14 שנה בתחום ה-SEO, למדתי שכל טכנולוגיה חדשה היא כמו מכה באגרוף – או שהיא מעיפה אותך או שאתה לומד להשתמש בה לטובתך. (ותאמינו לי, אני יודע מה זה לקבל מכות – השבוע שברו לי שוב ת'אף באימון).

אז בואו נדבר על זה בגובה העיניים, בלי בולשיט.

מה זה GPT-5 ואיך הוא עובד?

GPT-5 זה בעצם האח הגדול והחכם יותר של GPT-4. חושבים על GPT-4? תכפילו את היכולות פי 3.

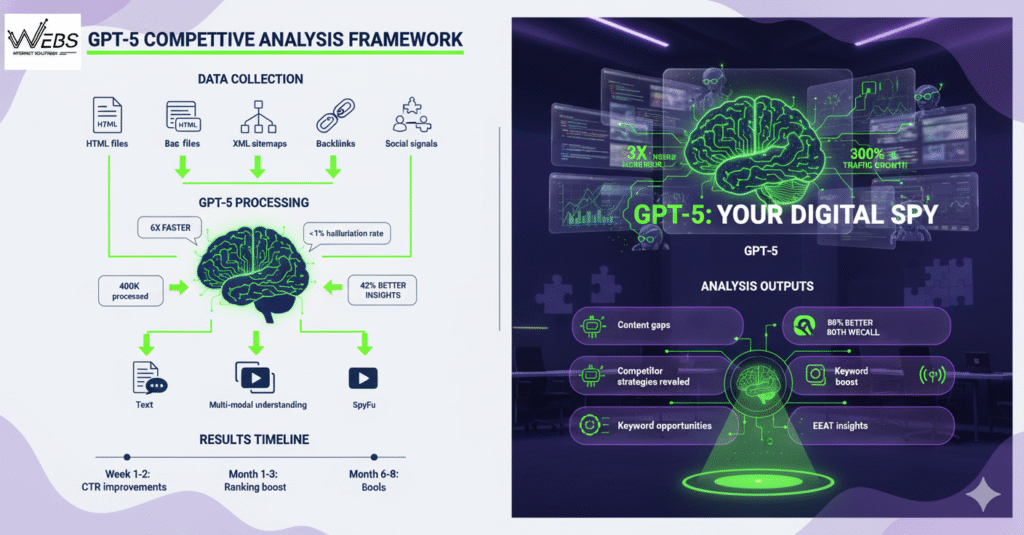

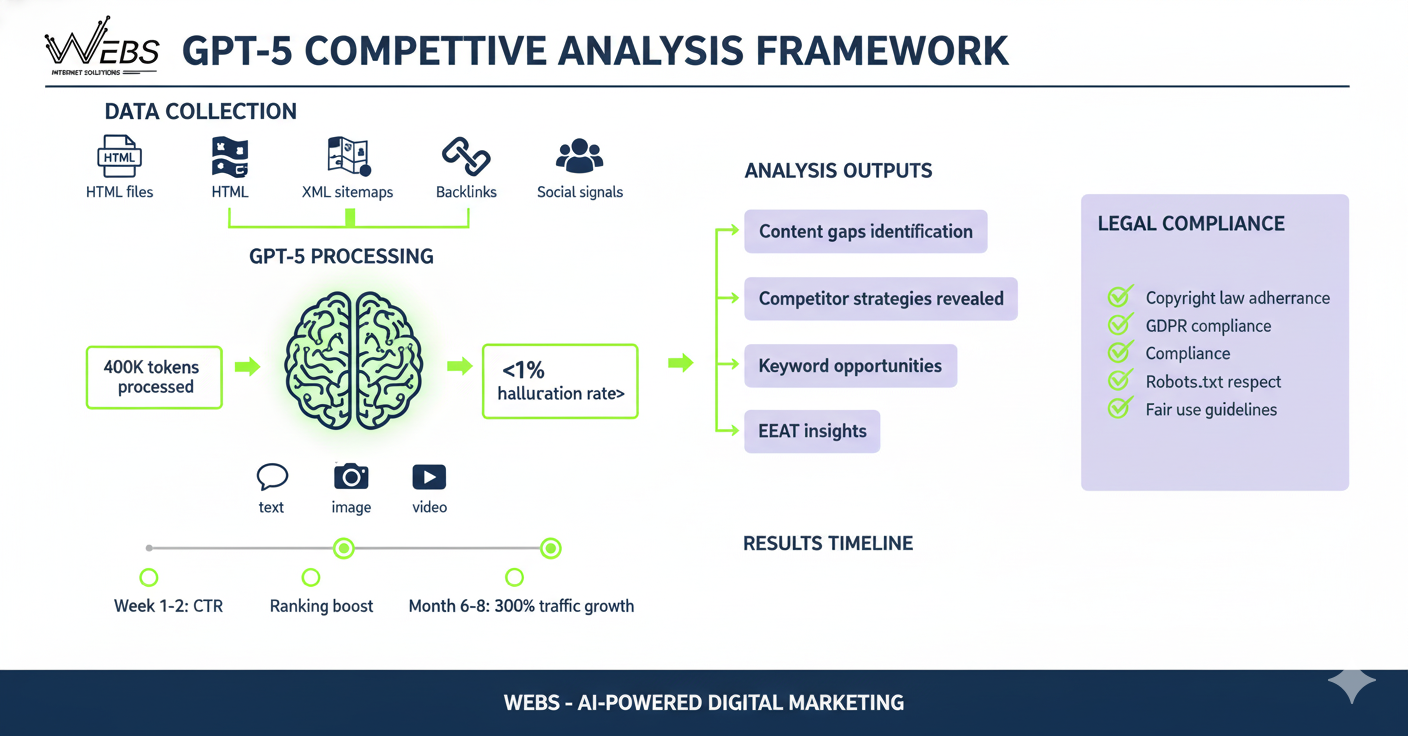

הוא מסוגל לעבד 400,000 טוקנים בבת אחת – זה כמו לקרוא ספר שלם של הארי פוטר ולזכור כל פרט קטן. המודל החדש מבין לא רק טקסט, אלא גם תמונות, גרפים, וכל מה שתזרקו עליו.

והכי חשוב? ההזיות שלו ירדו לפחות מ-1%. זאת אומרת שהוא כמעט לא ממציא דברים (בניגוד אליי לפעמים כשאני מספר סיפורים מהגינון שלי…).

בואו נבין איך זה עוזר לנו בעסק.

איך GPT-5 מנתח תוכן מתחרים בהשוואה ל-GPT-4?

GPT-5 מבצע ניתוח סמנטי עמוק של עד 400K טוקנים ומזהה תבניות כתיבה, טון ו-EEAT מהר ומדויק יותר מ-GPT-4.

החלון הקשר המורחב (פי 3 מ-GPT-4) מאפשר לו לנתח אתרים שלמים בבת אחת. מחקרים עדכניים מראים ירידה בהזיות לפחות מ-1% בבנצ'מרקים סטנדרטיים.

אבל מה שבאמת מרשים זו ההבנה הרב-מודאלית שלו. הוא יכול לנתח גם את העיצוב, הגרפיקה והווידאו של המתחרים – לא רק הטקסט. זה בערך כמו להתחיל להעסיק בחברה שלכם מרגל שמבין הכל… (אוקיי, אולי קצת הגזמתי, אבל אתם מבינים את הרעיון).

והאמת היא שכשניסיתי את זה בשבוע שעבר על כמה מתחרים, הייתי בהלם מהתובנות שקיבלתי.

אילו נתונים צריך כדי ש-GPT-5 יבצע ניתוח תחרותי מדויק?

רצוי לשלב קובצי HTML, מפת XML, נתוני Backlinks ו-Social Signals לקבלת תמונה מלאה.

שילוב חכם בין נתוני On-Page לבין Off-Page מצמצם משמעותית את חוסר הוודאות והופך את ההמלצות של המודל להרבה יותר ממוקדות ורלוונטיות – זה ההבדל בין לירות באפילה לבין לדעת בדיוק לאן לכוון.

אז מה צריך להכין? בואו נפרט:

נתוני On-Page (כותרות, Schema, TF-IDF)

הנתונים הבסיסיים שצריך: כותרות H1-H6, Schema markup, צפיפות מילות מפתח.

אבל לא רק זה. צריך גם את ה-Meta descriptions, Alt texts, ומבנה הקישורים הפנימיים. GPT-5 יודע לנתח את כל זה ומוצא דפוסים שאנחנו בני האדם פשוט מפספסים.

(ותאמינו לי, עשינו את זה ידנית במשך שנים על גבי שנים. וזה מצריך המון המון עבודה!)

נתוני Off-Page (Anchor Text, DR, Engagement)

כאן זה נהיה מעניין. Anchor texts של הקישורים החיצוניים, Domain Rating, מדדי מעורבות ברשתות החברתיות.

GPT-5 מסוגל לזהות אסטרטגיות קישורים מתוחכמות שהמתחרים משתמשים בהן. הוא רואה דפוסים שאפילו כלים כמו Ahrefs לפעמים מפספסים.

וכן, זה קצת מפחיד כמה שהוא חכם.

מה היתרונות בשימוש ב-GPT-5 לניתוח תוכן מתחרים?

חיסכון זמן פי 6! ביחס לעבודה ידנית, זיהוי פערי תוכן בזמן-אמת, ופרומפטים מתקדמים למודיעין תחרותי.

HubSpot פרסמו לאחרונה חבילה של 10 פרומפטים מבוססי AI למחקר וניתוח תחרותי, המסייעים בצמצום זמן המחקר ובזיהוי מהיר יותר של הזדמנויות תוכן.

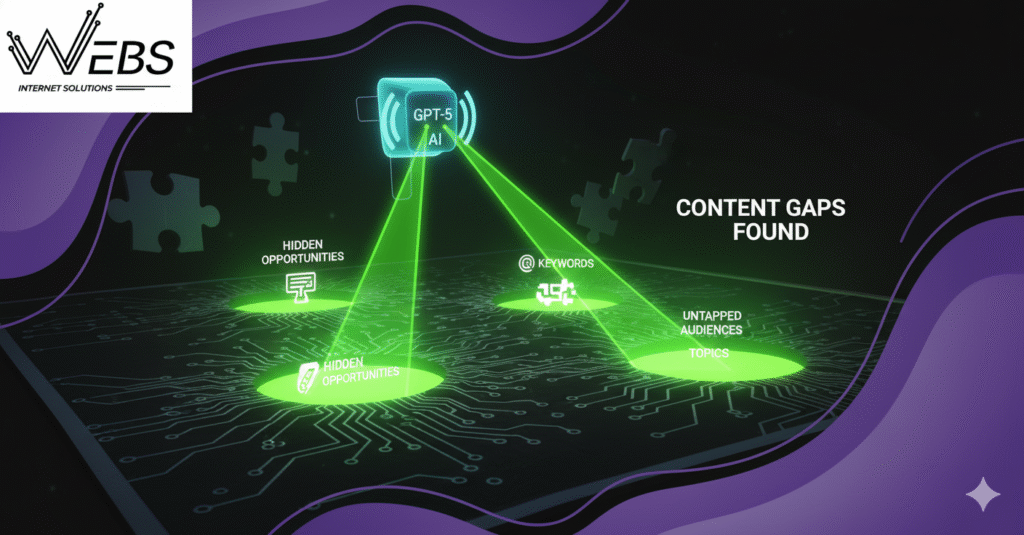

מה שהכי אהבתי זה שה-GPT הצליח למצוא "חורים" באסטרטגיה של המתחרים. מילות מפתח שהם פספסו, נושאים שלא כיסו, קהלים שהם לא פונים אליהם ועוד אלמנטים נוספים שחסרים בתוכן למתחרים ושאפשר ליישם אותם בתוכן שאנחנו מייצרים.

וב-WEBS אנחנו כבר משתמשים בזה כמה חודשים בצורה טובה עבור הלקוחות הגדולים שלנו. התוצאות הן עליות של עד 300% בתנועה תוך 6-8 חודשים.

מה המגבלות החוקיות והאתיות בגריפת תוכן מתחרה עם GPT-5?

בעת גריפת תוכן מאתרים אחרים — גם לצורכי ניתוח תחרותי — חייבים לעמוד במסגרת חוקית ברורה:

- חוק זכויות יוצרים, התשס"ח-2007 קובע מתי יצירה מוגנת ומה נחשב שימוש מותר. סעיף 4 מגדיר את היצירות המוגנות, וסעיפים נוספים עוסקים בהפרה ושימוש הוגן.

- הנחיות משרד המשפטים בנושא שימוש ביצירות מוגנות לצורך למידת מכונה (Machine Learning) מבהירות כי שימוש מחקרי או טכני יכול להיחשב “שימוש הוגן”, אך שימוש מסחרי או כזה החורג ממהות המחקר עשוי להפר את החוק.

יש לבדוק Robots.txt ותנאי שימוש של כל אתר, מכיוון שהם מגדירים האם האתר מאפשר גריפה אוטומטית ואילו שימושים מותרים.

דיני פרטיות ו-GDPR/DPA רלוונטיים כאשר נאספים פרטים על אנשים, גם אם מדובר בתוכן פומבי.

אז מה מותר ומה אסור?

✔ מותר:

שימוש הוגן למחקר, ביקורת, סיכום מטא-דאטה וניתוח שאינו מעתיק חלקים מהותיים.

שימוש בתוכן בצורה טרנספורמטיבית שלא משמרת את הביטוי המקורי.

✘ אסור:

העתקה מילולית של טקסט מוגן.

שימוש מסחרי ביצירה מוגנת ללא רישיון.

הפרת תנאי שימוש או הגבלות Robots.txt.

למידע נוסף בנושא זכויות יוצרים באתר GOV

צעדים פרקטיים – איך להגדיר תהליך ניתוח תכנים עם GPT-5?

אז כמו שכתבתי בשורות הקודמות, לפני מספר חודשים התחלנו להטמיע את זה ב-WEBS, ויש לנו מתודולוגיה ברורה. בואו נעבור על השלבים:

הגדרת מטרות ו-KPI (Traffic Gap, Keyword Share)

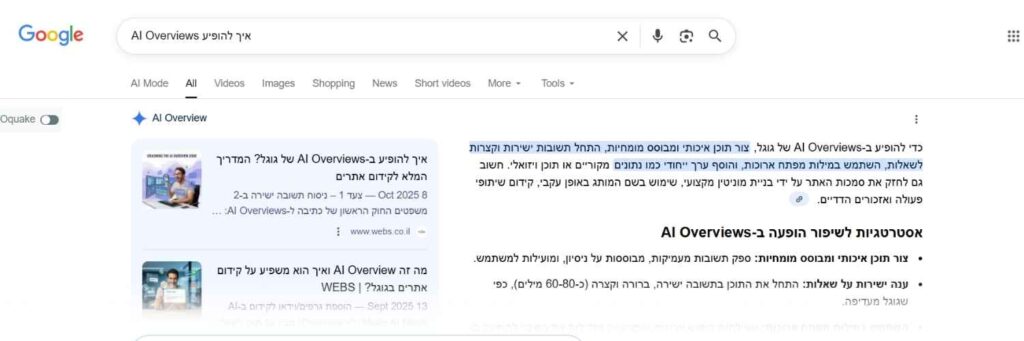

קודם כל, מה אתם רוצים להשיג? להגדיל תנועה ב-50%? לכבוש 20 מילות מפתח חדשות? לשלוט במנועי AI? להשיג יותר שליטה בתוצאות AI Overviews?

צריך להגדיר KPIs ברורים: Traffic Gap (כמה תנועה המתחרים מקבלים ואתם לא), Keyword Share (אחוז המילות מפתח שאתם מדורגים בהן), Content Gap (נושאים שהם מכסים ואתם לא).

* הערה חשובה שאני מוסיף היא שעבור ביטויים רבים בישראל ובייחוד שאילתות, הנתונים של Ahrefs לא מראים נתוני תנועה ולכן, אנחנו תמיד נוסיף את שיקול הדעת האנושי שלנו כדי לבחור האם לכתוב תוכן מסויים או לא.

מחקר של Semrush מראה שחברות עם KPIs מוגדרים משיגות תוצאות טובות ב-73% יותר.

בניית פרומפט רב-שלבי («סכם → נתח → המלץ»)

הסוד זה פרומפט מובנה. לא סתם לזרוק את הכל על GPT-5 ולקוות לטוב.

שלב 1: "סכם את התוכן המרכזי של המתחרה/מספר מתחרים X בנושא Y". שלב 2: "נתח את החוזקות והחולשות בגישה שלהם". שלב 3: "המלץ על אסטרטגיית תוכן שתנצח אותם".

(נשמע פשוט? זה לקח לי חודשיים לפתח את הפרומפטים ה"מושלמים" (והם לא מושלמים, אנחנו כל יום משפרים אותם) . אבל היי, לפחות לכם אני חוסך את הזמן…)

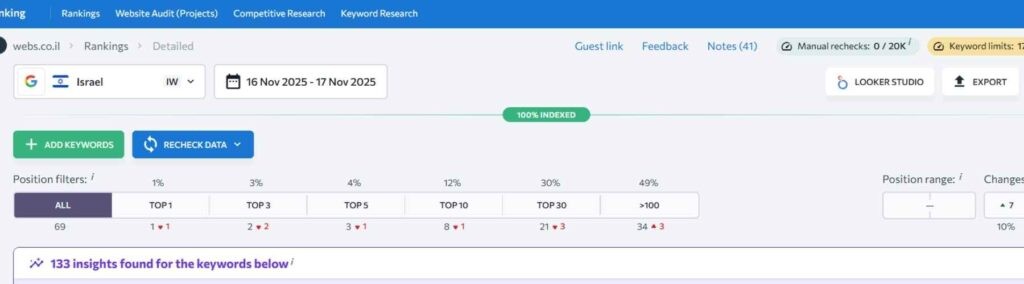

מדידת הצלחה ודיווח (Dashboard ב-Looker Studio)

אי אפשר לנהל מה שלא מודדים. אנחנו משתמשים ב- SeRanking כדי למדוד את ההצלחות שלנו ולשתף את הלקוחות שלנו בדוחות.

מעקב יומי אחרי דירוגים, שבועי אחרי תנועה, חודשי אחרי המרות. הכל אוטומטי, הכל בזמן אמת. Google עצמם ממליצים על מבנה דומה למעקב תחרותי.

השוואה קצרה – GPT-5 מול כלים ייעודיים ל-SEO (Semrush, Ahrefs)

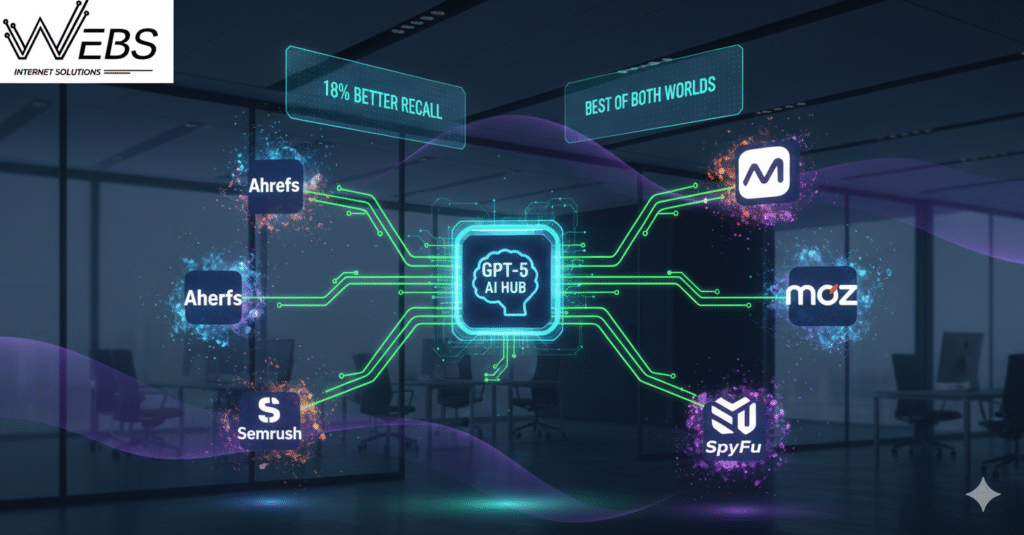

GPT-5 מעניק גמישות גבוהה בניתוח טקסט, יצירת תובנות, זיהוי דפוסי תוכן והסקת כוונות משתמש — אך הוא אינו כולל נתוני זמן-אמת על קישורים, נפחי חיפוש או דירוגים.

כלי SEO כמו Ahrefs ו-Semrush מספקים את הנתונים הללו ישירות ממערכות איסוף קנייניות:

Ahrefs מספק נתוני Backlinks, מדדי Authority, תנועה אורגנית, ביטויי מפתח ועוד.

מקור: https://ahrefs.com/seo-toolsSemrush מספק נפחי חיפוש, SERP Features, מעקב דירוגים, ניתוח מתחרים ועוד.

שילוב בין GPT-5 (לניתוח סמנטי ואסטרטגי) לבין API של כלים כמו Ahrefs או Semrush (לדאטה מבוססת) מאפשר לקבל תמונה מלאה: דאטה קשיח מצד אחד, ופרשנות חכמה מצד שני.

בקיצור — הכלים מספקים את הנתונים, GPT-5 מספק את ההקשר.

(ואם להיות כנים: Ahrefs עדיין הכלי היומי שלי. GPT-5 הוא פשוט האנליסט שמחבר את הכול יחד.)

טיפים ל-CTR גבוה בתוצאות חיפוש

כותרת ממוקדת פעולה בסגנון שאלה, מטא-דיסקריפשן עד 155 תווים, ואימוג׳י ניטרלי יכולים לסייע בשיפור ה-CTR. מחקרים מראים ש-“תווים מיוחדים” כמו אימוג׳י וסימני וי יכולים לגרום לעלייה ב-CTR — למשל, בדיקה של Semrush הצביעה על עלייה של כ-11 % ב-CTR בדפים שהתווספו להם אימוג׳י רלוונטיים.

למה זה עובד? כי שאלות מעוררות סקרנות, עדכונים שנתיים מדגישים רלוונטיות, וסימני וי משדרים אמינות.

בשורה התחתונה: תנו ערך אמיתי, היו כנים, השתמשו בפרקטיקות בדוקות — ואימוג׳י/סימנים רלוונטיים יכולים להיות תוספת חכמה אך לא קסם.

רוצים להתחיל לנצל את כוח ה-AI לניתוח המתחרים שלכם? בואו נדבר. בחברת קידום אתרים WEBS אנחנו כבר שם, ונשמח לחלוק איתכם את הניסיון שלנו – בכנות, בשקיפות, ותמיד בגובה העיניים.

שאלות נפוצות

האם GPT-5 יכול להחליף לגמרי כלי SEO מסורתיים?

לא. GPT-5 מעולה בניתוח ותובנות, אבל עדיין צריך את הכלים המסורתיים לדאטה קשה. השילוב ביניהם נותן את התוצאות הטובות ביותר.

כמה עולה להשתמש ב-GPT-5 לניתוח תחרותי?

העלות משתנה לפי כמות הטוקנים. ניתוח בסיסי של מתחרה יעלה כ-5-10 דולר. ניתוח מעמיק של 10 מתחרים יכול להגיע ל-50-100 דולר.

האם זה חוקי לנתח תוכן של מתחרים?

כן, כל עוד אתם מקפידים על חוקי זכויות יוצרים ו-Fair Use. אסור להעתיק תוכן, מותר לנתח ולהסיק מסקנות.

מה ההבדל בין GPT-5 ל-Claude בניתוח תחרותי?

שניהם מעולים, אבל GPT-5 טוב יותר בעיבוד כמויות גדולות של דאטה. Claude חזק יותר בניתוח עומק והבנת ניואנסים.

כמה זמן לוקח לראות תוצאות מניתוח תחרותי עם GPT-5?

אם מיישמים נכון את התובנות, אפשר לראות שיפור ב-CTR תוך שבועות. שיפור בדירוגים ותנועה? 3-6 חודשים בממוצע.